„Šiuo metu vykstantis karas yra persikėlęs ir į skaitmeninę erdvę, kur vyksta provokacijos, kibernetinės atakos, pateikiama melaginga informacija ir iškreipti faktai. Taip siekiama paveikti žmones ir įtikinti juos viena tiesa. Dar vienas reiškinys, kuris gali padažnėti dėl vykstančio karo – „deepfake“ klastotės. Tai – itin tikroviškai suklastotas vaizdinis arba garsinis turinys, sukurtas pasitelkiant dirbtinio intelekto ir mašininio mokymosi technologijas“, – sako T. Stamulis.

Kokiu tikslu kuriamos „deepfake“ klastotės?

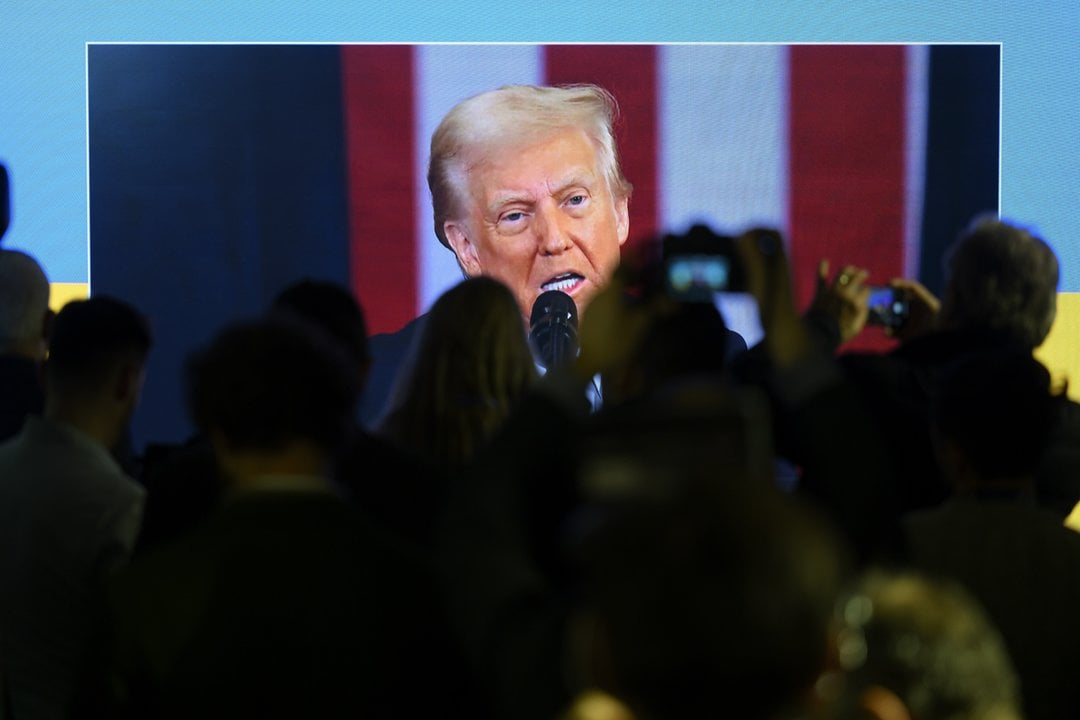

Kaip aiškina IT ekspertas, „deepfake“ klastotės daugiausiai buvo naudojamos kuriant filmus, tačiau vis dažniau ši technologija yra pasitelkiama siekiant padaryti įtaką, ypač politinių temų kontekste. Pavyzdžiui, prieš kelerius metus Gabono prezidentas Ali Bongo buvo dingęs iš viešosios erdvės, o vėl jam pasirodžius, buvo mesti kaltinimai, kad vaizdo įrašas yra klastotė. Buvęs JAV prezidentas Donaldas Trumpas taip pat ne kartą jau buvo parodytas suklastotame vaizdo įraše. Tiesa, klastotojams teko už tai atsakyti, o vienas vaizdo įrašas netgi buvo užblokuotas JAV ir Kanadoje.

Dar vienas atvejis, kuris leidžia pamatyti pastarosios technologijos galimybes – gerai žinomo aktoriaus Tomo Cruise'o „deepfake“ paskyra socialiniame tinkle „TikTok“. Jame galima rasti suklastotų vaizdo įrašų, kuriuose aktorius atlieka įvairius veiksmus, triukus ir užsiima kokia nors veikla.

Tačiau ekspertas įspėja, kad net ir pramoginiam turiniui sukurtos „deepfake“ klastotės neturėtų būti toleruojamos. „Tai yra klastotės, kuriomis mes tikime ir jas žiūrime, dalinamės su kitais. Jeigu žmogui patinka vienas ar kitas visuomenėje gerai žinomas asmuo, bet jis pats nesidalina savo veikla, „deepfake“ turinys taip įtrauks, kad tai ilgainiui gali tapti realybe ir vaizdo įrašai bus stebimi lyg jie būtų autentiški. Kitaip tariant, žmogus bus apgaudinėjamas“, – aiškina T.Stamulis.

Klastočių tipai

Naudojant „deepfake“ technologijas galima pakeisti ar užmaskuoti asmens veidą nuotraukoje, vaizdo įraše. Įmanoma pakeisti originalų balsą, koreguoti veido išraiškas, mimiką, lūpų judesius.

„Yra skirtingos „deepfake“ kūrimo technologijos ir metodai. Pavyzdžiui, vieno asmens veidas pakeičiamas kitu. Taip pat dažnu atveju būna pakeičiami burnos judesiai. Asmuo, kurio kalbą norima suklastoti, šneka dirbtinio intelekto sugeneruotą kalbą. Arba gali būti klonuojamas pats balsas, tai reiškia, kad atrinkus konkretaus asmens balso įrašus, sukuriama dirbtinė to asmens balso versija“, – priduria T. Stamulis.

T. Stamulis įvardina dar vieną giliosios klastotės metodą – nuotraukų klastojimas. Tai toks metodas, kai dirbtinio intelekto pagalba sukuriami nauji ir realybės neatitinkantys vaizdai. Tokiu būdu sukuriami neegzistuojantys asmenys arba objektai, pateikiama iškreipta informacija.

Didžiausia grėsmė kyla tuomet, kai giliosios klastotės pradedamos naudoti norint pakenkti. Ši technologija leidžia taip sukurti norimą turinį, kad paprastam žmogui atskirti bus praktiškai neįmanoma. Dažniausiai klastotėms yra pasirenkami informacijos šaltiniai, kuriuose naujiena plinta labai greitai, pavyzdžiui, socialiniai tinklai. Taip klastotė gali pasiekti milijonus žmonių per labai trumpą laiką ir turėti neigiamos įtakos visuomenei.

Kaip atpažinti giliąsias klastotes?

Nors technologijos ir viešai prieinama informacija leidžia sukurti itin tikroviškas klastotes, visgi ekspertas įvardina esmines detales, kurios padės atpažinti giliąją klastotę:

- Pirmiausiai reikia atkreipti dėmesį į informacijos šaltinį. Jeigu vaizdo ar garso medžiaga dalinamasi iš įtartinų profilių, paskyrose nėra jokios asmeninės informacijos, nuotraukų, tikėtina, kad profilis yra netikras ir sukurtas specialiai, kad būtų skleidžiamos klastotės ir kitokia kontraversiška informacija.

- Atkreipti dėmesį į kalbančiojo lūpas. Jeigu jos juda nenatūraliai, atrodo lyg įklijuotos ant viršaus, verta patikrinti informacijos šaltinį. Tokie vaizdo įrašai dažniausiai plinta tik socialiniuose tinkluose, forumuose ar grupėse, jų neįmanoma rasti internete naudojantis paieška.

- Patikrinti ausų arba auskarų asimetriją – netikrose nuotraukose žmogaus ausys išsidėsto ne viename lygyje, o moterys dažniausiai būna įsisegusios vieną auskarą arba abu, bet ne vienodus. Suklastotuose vaizdo ar garso įrašuose dažnai būna girdimas foninis triukšmas, balsas skamba robotiškai, girdimas keistas tarimas.

- Jeigu abejojama nuotrauka arba vaizdo įrašu, reikia atkreipti dėmesį į kokybę. Klastočių vaizdo kokybė dažnu atveju būna prasta – vaizdai neryškūs arba nesuderinti, pavyzdžiui, skiriasi asmens veido, kaklo ir likusio kūno spalvos, kūno dalių sujungimai.

Taip pat svarbu įvertinti smulkmenas. Galbūt matosi keisti objektai, nenatūraliai atrodančios kūno dalys ar į akis krenta detalės, kurių neturėtų būti arba jos yra neįprastai susilieję. Tai gali reikšti, kad susidūrėte su giliosios klastotės turiniu.